Accélérer l’adoption d’APIs : Génération Automatique de Tutoriels en Python

Automatisez la génération de tutoriels pour vos APIs avec Google Gemini AI

Google Gemini AI simplifie l’intégration des APIs en générant automatiquement des tutoriels complets avec des extraits de code “Get Started”, facilitant ainsi la compréhension et l’utilisation rapide de vos APIs par les développeurs. Cela se traduit par une adoption plus rapide et un écosystème API plus performant.

Automatisation de la création de tutoriels avec Google Gemini 1.5 Pro sur Vertex AI

Dans la première partie de ce guide, nous vous avons montré comment utiliser Gemini pour créer des tutoriels Python pour vos APIs. Dans cette deuxième partie, nous irons plus loin en automatisant ce processus à grande échelle en utilisant Gemini 1.5 Pro sur Vertex AI. En téléchargeant simplement votre Spécification OpenAPI dans un Bucket Google Cloud Storage (GCS), vous pouvez automatiquement générer des tutoriels “Get Started” en Python au format Markdown pour toutes vos APIs dans un autre Bucket GCS.

Cette approche automatisée est parfaite pour s’intégrer dans vos flux de travail existants, tels que la génération automatique de tutoriels pour les nouvelles APIs publiées sur votre portail développeur. Si ce n’est pas déjà fait, consultez la première partie pour une meilleure compréhension de la manière de solliciter efficacement Gemini.

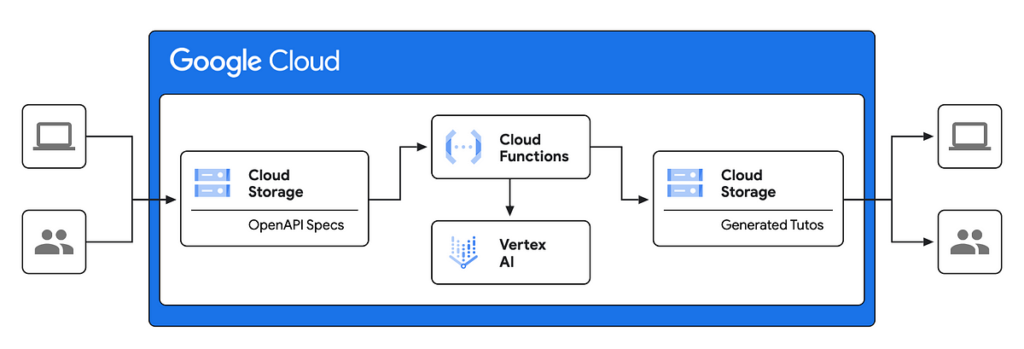

Architecture de haut niveau du processus

Le schéma ci-dessous présente une architecture de haut niveau de notre solution. Cette architecture exploite les fonctions Cloud Google et les capacités IA (Vertex AI avec Gemini) pour automatiser la création des tutoriels, simplifiant le processus d’intégration pour les développeurs utilisant les APIs.

Jetons un coup d’œil aux différents éléments constitutifs de cette architecture :

Spécifications OpenAPI (Stockage Cloud) :

Le processus commence par le téléchargement des Spécifications OpenAPI (descriptions détaillées de l’API) dans un Bucket Google Cloud Storage. Cela sert de source d’entrée pour le processus de génération des tutoriels.

Fonctions Cloud :

Une Fonction Cloud est déclenchée chaque fois que de nouvelles Spécifications OpenAPI sont téléchargées dans le Bucket de stockage. Cette fonction agit comme l’orchestrateur du flux de travail.

Vertex AI :

La Fonction Cloud invoque Vertex AI (SDK Python) pour traiter les Spécifications OpenAPI et générer les tutoriels “Get Started”.

Tutoriels Générés (Stockage Cloud) :

Les tutoriels générés, probablement au format markdown (.md), sont ensuite stockés dans un autre Bucket Cloud Storage.

Utilisateurs :

Ces tutoriels peuvent ensuite être intégrés dans un portail développeur.

En résumé, cette architecture exploite les capacités sans serveur (Fonctions Cloud) et IA (Vertex AI avec Gemini) de Google Cloud pour automatiser la création de tutoriels, simplifiant le processus d’intégration pour les développeurs utilisant les APIs.

Détails de la mise en œuvre

Dans les prochaines sections, nous aborderons une mise en œuvre “PoC” de l’architecture présentée ci-dessus sur GCP.

Stockage Cloud :

Créez deux Buckets, l’un pour stocker les fichiers de Spécifications OpenAPI (entrée) et l’autre pour stocker les tutoriels générés (sortie).

Vertex AI :

Rendez-vous sur “Vertex AI” dans votre console GCP et cliquez sur “Language” dans le menu de gauche sous “Vertex AI Studio”, puis sur “Text Prompt”.

Activez les APIs GCP nécessaires pour ce tutoriel dans votre projet.

Nous sommes prêts à tester l’ensemble du flux de travail de bout en bout.

Source : medium.com