Azure Open AI dévoile le modèle GPT-4o : Texte et Images. Upgradez votre expérience maintenant !

Upgrade to GPT-4o for Image Processing

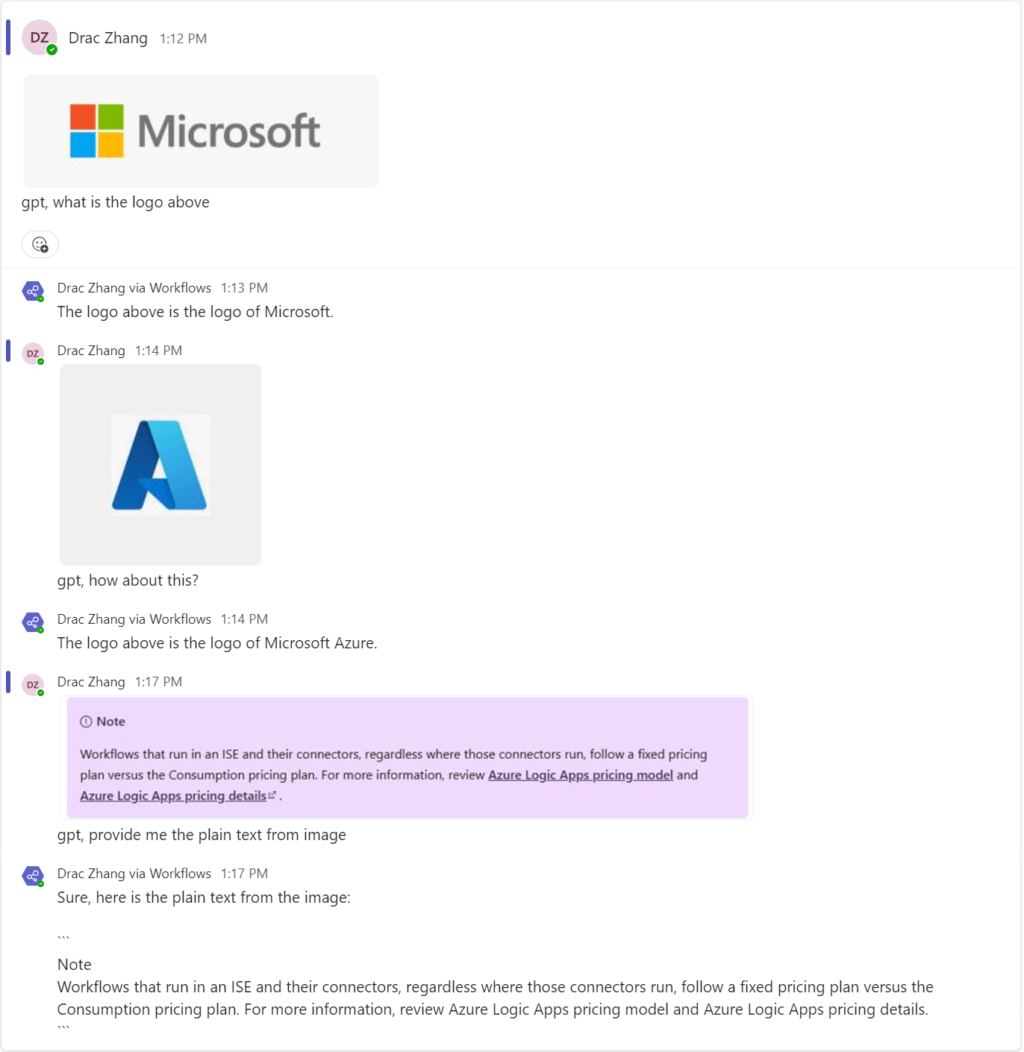

Le modèle GPT-4o d’Azure Open AI est désormais disponible pour prendre en charge le traitement du texte et des images dans un seul modèle. Cela lui permet de gérer plusieurs types de données simultanément. Découvrez comment passer à GPT-4o avec la capacité de traiter les images.

Prérequis

La plupart des prérequis restent les mêmes, mais au lieu de GPT-3.5, nous avons besoin d’un déploiement GPT-4o dans l’environnement Azure Open AI. Assurez-vous que votre région actuelle prend en charge GPT-4o en consultant la documentation. Sinon, vous devrez déployer un nouveau Azure Open AI.

Mécanisme

Dans l’API Open AI, lorsque vous envoyez une image à l’API, vous devez fournir l’image sous forme de contenu encodé en base64. Il vous suffit donc de récupérer les données binaires de l’image du canal Teams, ce qui peut être réalisé en utilisant Teams Graph API.

Modèle et paramètres

Vous pouvez trouver le modèle sur Github et les paramètres du modèle comprennent l’api key de la ressource Open AI, l’endpoint de l’API Open AI, le mot-clé du canal Teams, etc.

Problèmes Connus

En plus des problèmes connus du précédent blog, un nouveau problème a été identifié. Dans l’action “Envoyer une requête HTTP Graph Microsoft” du connecteur “Microsoft Teams”, il y a un problème qui ne permet pas de répondre correctement au contenu hébergé en tant que données binaires. Cela entraîne l’utilisation d’une “Requête HTTP” supplémentaire et nécessite une authentification manuelle après le déploiement.

Source : techcommunity.microsoft.com