Comment la formation d’un modèle sur un cluster 16,384 GPU a surmonté 419 failles en 54 jours ?

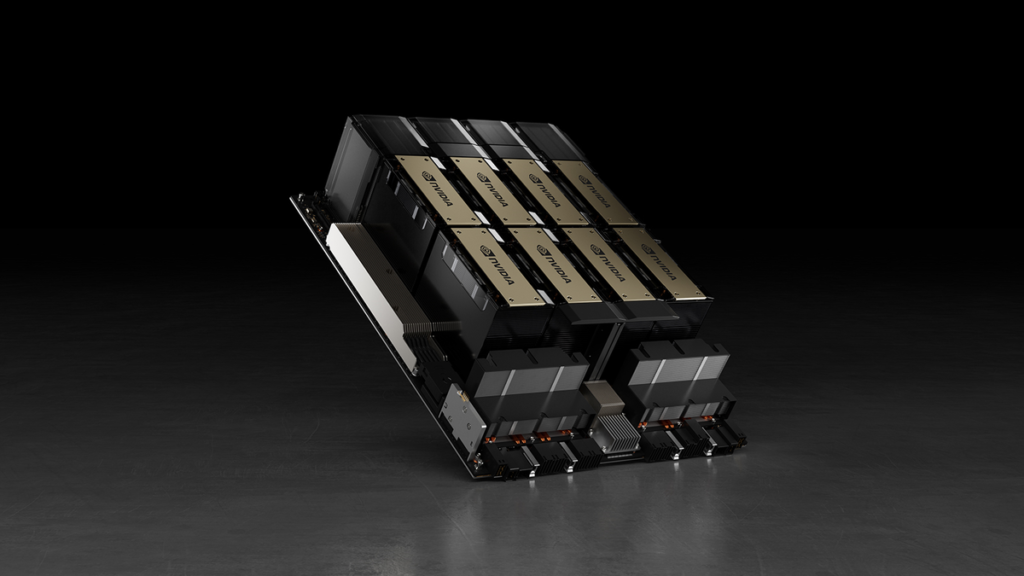

La formation de modèle Llama 3 405B de Meta sur un cluster contenant 16 384 GPU Nvidia H100 80 Go a connu 419 pannes de composants inattendues en 54 jours, soit une panne toutes les trois heures en moyenne. Ces pannes sont principalement causées par des problèmes de GPU ou de mémoire HBM3 embarquée. Les supercalculateurs sont des dispositifs complexes avec des milliers de processeurs, des centaines de milliers d’autres puces et des centaines de kilomètres de câbles, ce qui les rend sujets à des pannes fréquentes.

Impact des pannes sur la formation

La formation synchrone de 16 384 GPU rend le système vulnérable aux pannes, pouvant entraîner l’interruption de tout le processus de formation en cas de panne d’un seul GPU. Cependant, l’équipe Llama 3 a maintenu un temps de formation effectif de plus de 90%. Sur un instantané de pré-formation de 54 jours, 466 interruptions ont été enregistrées, dont 47 planifiées et 419 inattendues, principalement dues à des problèmes matériels.

Causes des interruptions inattendues

Des problèmes de GPU et de mémoire HBM3 représentent une grande partie des interruptions inattendues, suivis de divers autres facteurs tels que les bugs logiciels, les câbles réseau et les adaptateurs réseau. L’équipe de Meta a développé des outils de diagnostic propriétaires pour améliorer l’efficacité et a utilisé des outils tels que le registre de vol de NCCL de PyTorch pour résoudre rapidement les problèmes.

Gestion des pannes et des ralentissements

Des outils spécialisés ont été utilisés pour identifier les GPUs en rade et prioriser les communications problématiques, ce qui a permis de minimiser les ralentissements et de maintenir l’efficacité globale de la formation. Les fluctuations de température et de consommation d’énergie ont également eu un impact sur les performances, mais ont été gérées efficacement par l’équipe de formation de Meta.

En considérant le nombre élevé de pannes survenues sur le cluster de 16 384 GPU en 54 jours, il est intéressant de se demander comment un cluster de 100 000 GPU H100 réagirait face à de telles pannes, ce qui souligne l’importance de développer des systèmes résilients aux échecs potentiels.

Source : www.tomshardware.com