La hausse fulgurante de Nvidia en 2023 et 2024 : un succès inattendu

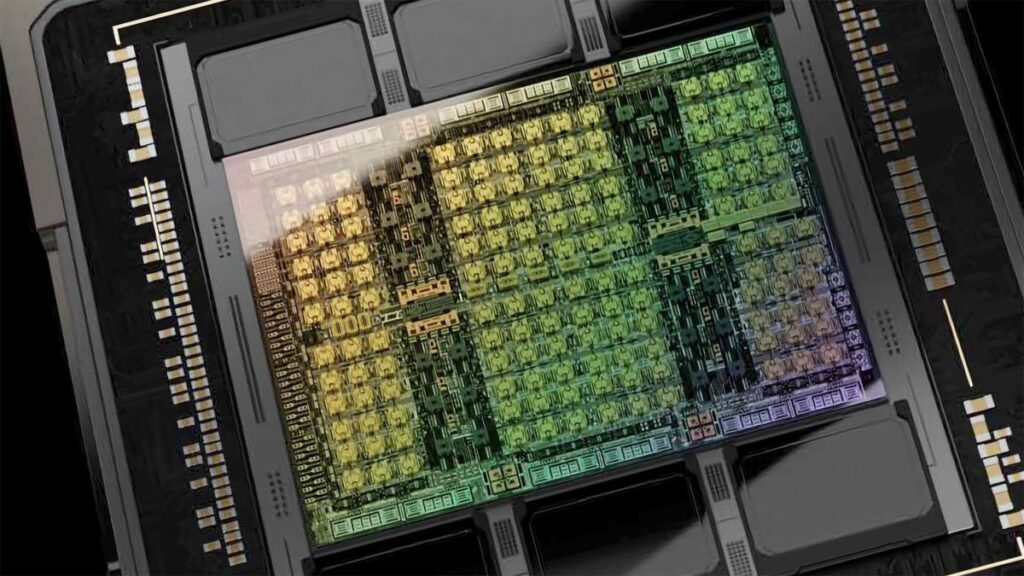

La montée en flèche de Nvidia en 2023 et 2024 a été alimentée par une demande explosive de GPU dans le secteur de l’IA, principalement aux États-Unis, dans les pays du Moyen-Orient et en Chine. En raison des restrictions à l’exportation aux États-Unis et du fait que Nvidia ne peut pas vendre ses processeurs haut de gamme Hopper H100, H200 et H800 à la Chine sans une licence d’exportation du gouvernement, elle vend à la place ses GPU HGX H20 dégradés à des entités en Chine. Cependant, bien que dégradé, le HGX H20 se vend extrêmement bien selon l’analyste Claus Aasholm. Vous pouvez voir les performances de vente du produit dans le tableau intégré dans le tweet ci-dessous.

Ventes de produits Nvidia

“Le système H20 dégradé qui respecte les règles d’embargo pour la Chine se comporte incroyablement bien”, a écrit Aasholm. “Avec une croissance de 50%, trimestre après trimestre, il s’agit du produit le plus réussi de Nvidia. L’activité H100 n’a ‘que’ augmenté de 25% Trimestriellement”.

D’après les conclusions de Claus Aasholm, Nvidia gagne des dizaines de milliards de dollars en vendant le GPU HGX H20 malgré ses performances considérablement réduites par rapport au H100 complet. L’intelligence artificielle est en effet une méga-tendance qui stimule les ventes de tous les types de matériel de centre de données, y compris les GPU Hopper de Nvidia, y compris le HGX H20.

Les principales économies mondiales – les États-Unis et la Chine – se disputent les capacités maximales en matière d’IA. Pour l’Amérique, la croissance est plus ou moins naturelle : plus d’argent et plus de matériel égalent des capacités plus élevées, mais ce n’est pas suffisant. OpenAI seul génère des milliards, mais il a besoin de plus pour obtenir plus de matériel et, par conséquent, des capacités de formation et d’inférence en IA.

Malgré toutes les restrictions, les capacités d’IA de la Chine – tant en matière de matériel que de développement de grands modèles – sont en expansion. Il s’est avéré la semaine dernière que l’entreprise chinoise d’IA Deepseek a révélé dans un article qu’elle avait formé son modèle linguistique DeepSeek-V3 Mixture-of-Experts (MoE) de 671 milliards de paramètres sur un cluster de 2 048 GPU Nvidia H800 et que cela avait pris deux mois, un total de 2,8 millions d’heures-GPU. En comparaison, Meta a investi 11 fois plus de ressources informatiques (30,8 millions d’heures-GPU) pour former Llama 3, qui comporte 405 milliards de paramètres, en utilisant 16 384 GPU H100 sur 54 jours.

Au fil du temps, les accélérateurs domestiques de la Chine provenant d’entreprises telles que Biren Technologies et Moore Threads pourraient s’imposer dans ce qui est maintenant un quasi-monopole pour Nvidia dans les centres de données chinois. Cependant, cela ne peut tout simplement pas se produire du jour au lendemain.

Source : www.tomshardware.com