La révolution de l’IA : Google, Amazon, Meta, et Microsoft investissent des milliards

La révolution de l’intelligence artificielle dans le secteur des nouvelles technologies

L’intelligence artificielle est en train de transformer profondément le secteur de l’informatique, au point d’être considérée comme la plus grande révolution depuis les débuts de la World Wide Web. Les grandes entreprises technologiques sont en train de repenser leurs infrastructures informatiques pour accueillir cette nouvelle ère de l’IA, des composants minuscules jusqu’à la façon dont les ordinateurs sont hébergés et alimentés. Ces changements affectent non seulement le secteur de la technologie, mais aussi la finance, l’énergie et les communautés locales.

La montée en puissance des data centers pour l’intelligence artificielle

Pendant deux décennies, les géants de la tech ont construit des centres de données partout dans le monde pour gérer le trafic en ligne vers leurs services internet, tels que les moteurs de recherche, les applications de messagerie et les sites de commerce électronique. Mais ces installations étaient relativement légères par rapport à ce qui se prépare. En 2006, Google a ouvert son premier centre de données dans l’Oregon, dépensant environ 600 millions de dollars pour le projet. Récemment, OpenAI et plusieurs partenaires ont annoncé un plan d’investissement de près de 100 milliards de dollars dans de nouveaux centres de données, débutant par un campus au Texas et visant à investir jusqu’à 400 milliards de dollars supplémentaires dans ces infrastructures à travers les États-Unis.

La demande croissante en puissance de calcul et en électricité de la part des entreprises technologiques dépasse actuellement ce que le monde peut fournir. Des accords ont été conclus pour construire et déployer une nouvelle génération de réacteurs nucléaires. L’objectif ambitieux de ces entreprises est de créer une intelligence artificielle générale, capable de faire tout ce que le cerveau humain peut réaliser, et elles estiment que disposer de plus de puissance de calcul est essentiel pour y parvenir.

L’évolution des puces informatiques pour l’IA

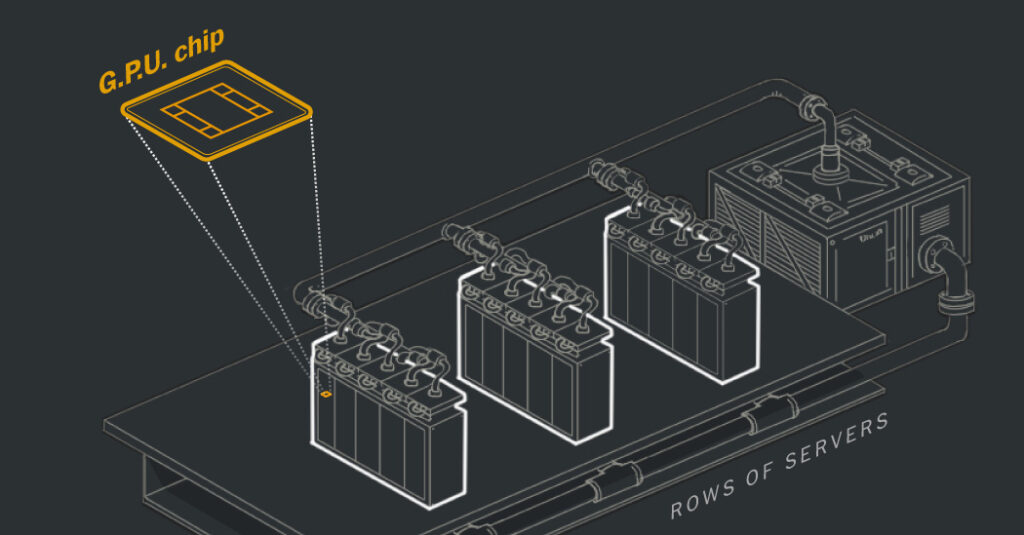

Le bond en avant spectaculaire réalisé dans le domaine de l’informatique pour l’IA est le fruit de l’utilisation de puces informatiques spécialisées appelées unités de traitement graphique, ou GPUs. Ces puces, initialement conçues pour le rendu graphique des jeux vidéo, se sont avérées idéales pour exécuter les calculs nécessaires au fonctionnement des réseaux neuronaux, à la base des chatbots et autres technologies d’IA de pointe.

Contrairement aux puces centrales traditionnelles (CPUs) capables d’effectuer un seul calcul à la fois, les GPUs opèrent en parallèle et peuvent effectuer des milliers de calculs simultanément, permettant aux réseaux neuronaux d’analyser des quantités massives de données. Les entreprises technologiques ont donc commencé à utiliser un nombre croissant de GPUs pour développer des technologies d’IA de plus en plus puissantes.

L’impact sur les data centers et la consommation d’électricité

Ces nouveaux data centers remplis de GPUs engendrent une demande d’électricité sans précédent. Les besoins en puissance devraient continuer de croître de manière exponentielle, mettant à rude épreuve les infrastructures électriques locales. Les data centers ont consommé environ 4,4 % de l’électricité totale aux États-Unis en 2023, et ce chiffre pourrait tripler d’ici 2028, selon un rapport du département de l’Énergie.

Les nouvelles infrastructures d’IA demandent également à repenser entièrement les systèmes de refroidissement des ordinateurs. Les systèmes d’IA générant une chaleur importante, une nouvelle méthode de refroidissement par eau a été adoptée. En parallèle, les entreprises redoublent d’efforts pour trouver des sources d’électricité suffisantes, certaines se tournant même vers l’énergie nucléaire.

Source : www.nytimes.com