Micron dévoile ses nouvelles mémoires HBM3E de 36 GB pour l’IA et le calcul haute performance

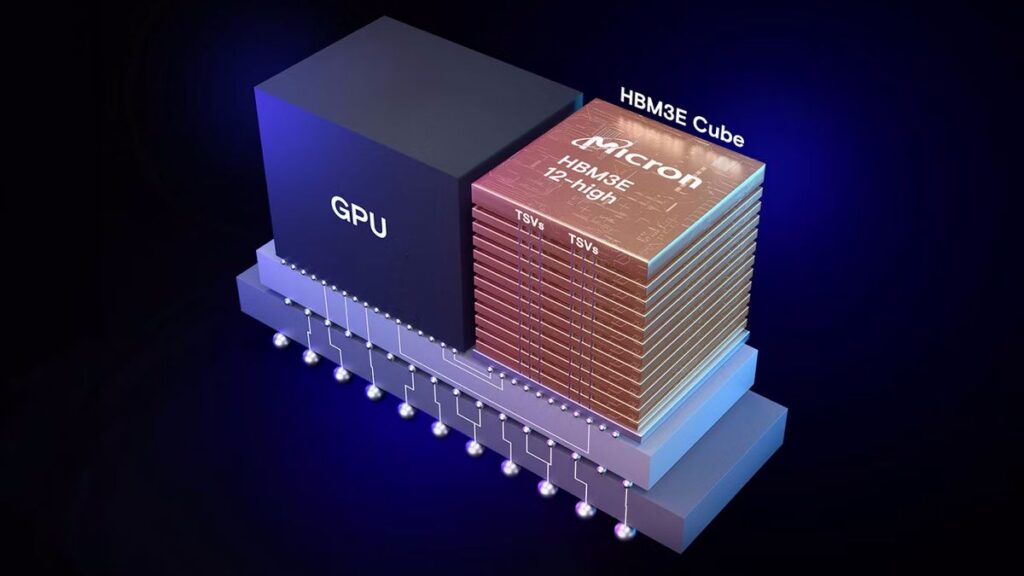

Les dernières innovations de Micron dans le domaine de la mémoire pour les processeurs de pointe dédiés aux charges de travail en intelligence artificielle (IA) et calcul à haute performance (HPC) ont été annoncées officiellement. Les empilements de mémoire 12-Hi HBM3E de Micron offrent une capacité de 36 Go, idéale pour les processeurs de pointe tels que les GPU Nvidia H200 et B100/B200.

Capacité et performances améliorées

Les empilements de mémoire 12-Hi HBM3E de Micron offrent une capacité de 36 Go, ce qui représente une augmentation de 50% par rapport aux versions précédentes en 8-Hi, qui possédaient 24 Go. Cette capacité accrue permet aux centres de traitement de données d’exécuter des modèles d’IA plus importants, comme Llama 2, avec jusqu’à 70 milliards de paramètres sur un seul processeur. Cela élimine la nécessité de décharger fréquemment le CPU et réduit les retards de communication entre les GPU, accélérant ainsi le traitement des données.

En termes de performances, les empilements de mémoire 12-Hi HBM3E de Micron offrent plus de 1,2 To/s de bande passante mémoire avec des taux de transfert de données dépassant 9,2 Gb/s. Selon l’entreprise, malgré une capacité mémoire 50% plus élevée que celle des concurrents, le HBM3E de Micron consomme moins d’énergie que les empilements HBM3E en 8-Hi.

Technologie avancée pour une validation rapide

Les dispositifs de mémoire HBM3E en 12-Hi de Micron comprennent un système de test de mémoire intégré entièrement programmable (MBIST) pour garantir une mise sur le marché plus rapide et une fiabilité accrue pour ses clients. Cette technologie peut simuler le trafic au niveau du système à pleine vitesse, permettant des tests approfondis et une validation plus rapide des nouveaux systèmes.

Partenariat stratégique avec TSMC

Les dispositifs de mémoire HBM3E de Micron sont compatibles avec la technologie d’empaquetage chip-on-wafer-on-substrate (CoWoS) de TSMC, largement utilisée pour l’empaquetage de processeurs d’IA tels que les Nvidia H100 et H200.

“TSMC et Micron entretiennent un partenariat stratégique de longue date”, a déclaré Dan Kochpatcharin, responsable de la division Ecosystem and Alliance Management chez TSMC. “Dans le cadre de l’écosystème OIP, nous avons travaillé en étroite collaboration pour permettre au système basé sur le HBM3E de Micron et à la conception d’empaquetage chip-on-wafer-on-substrate (CoWoS) de prendre en charge l’innovation en matière d’IA de nos clients.”

Des unités de mémoire 12-Hi HBM3E prêtes pour la production de Micron sont déjà expédiées à des partenaires industriels clés pour des tests de qualification dans tout l’écosystème d’IA.

Micron travaille déjà sur ses solutions de mémoire de nouvelle génération, y compris le HBM4 et le HBM4E, pour répondre aux exigences croissantes en matière de mémoire avancée utilisée par les processeurs d’IA, y compris les GPU Nvidia basés sur les architectures Blackwell et Rubin.

Source : www.tomshardware.com